在现代软件开发中,静态代码分析已成为保障代码质量和安全性的重要一环。Coverity作为业界领先的商业静态分析工具,其高精度漏洞识别能力被广泛应用于航空航天、汽车、工业软件以及互联网企业的CI/CD流程中。随着项目规模不断扩大,单次代码分析的时间成本也逐渐成为开发团队的瓶颈。为了缓解这一问题,Coverity引入了并行分析机制,通过多核处理、分布式资源调度等手段,有效提升了分析性能与效率。本文将详细探讨Coverity如何实现并行分析以及Coverity并行分析如何提高效率,并结合实际部署建议,为用户构建高效静态分析流程提供参考。

一、Coverity如何实现并行分析

Coverity的分析流程主要分为三个阶段:预处理(cov-build)、中间结果存储(intermediate emit)和缺陷检测分析(cov-analyze)。其中,cov-analyze是分析性能的主要影响环节,而并行分析能力正是围绕这个阶段展开优化的。

1. 支持多线程并发分析

Coverity在设计之初就支持多线程架构,可以在分析阶段将工作分发到多个CPU核心上:

使用 --threads 参数指定线程数,例如:

cov-analyze --dir idir --threads 8

默认情况下Coverity会自动检测CPU核心数,并使用其中的一部分进行分析;

可通过 cov-configure 中设置编译器参数,确保每个文件的分析任务互不干扰,从而实现高并发。

这种方式适合在单机多核服务器环境中运行,可以充分利用多核计算资源。

2. 模块级并行分析(Component-based Analysis)

对于大型项目,Coverity可以将整个代码库划分为多个子模块或组件,分别进行并行分析:

使用cov-build生成每个模块独立的中间目录(idir);

在多个分析节点(或线程)上分别运行 cov-analyze;

最后使用 cov-merge 将所有分析结果合并成统一的 defect report。

这种“任务分拆 + 并行执行 + 合并输出”的流程,极大提升了大型项目分析的可扩展性和执行效率,尤其适合持续集成系统中的分布式分析。

3. 分布式并行分析(Distributed Analysis with Coverity Connect)

在企业级部署中,Coverity通过其 Web 服务端 Coverity Connect 和 Coverity Analysis Server 支持真正的分布式并行分析:

多个分析节点部署在不同服务器上,每个节点可处理一部分分析任务;

分析服务调度器将任务按模块或文件粒度分配给各节点;

最终通过 Coverity Connect 聚合分析数据,供开发者进行图形化审阅。

此模式常见于使用 Jenkins、GitLab CI、TeamCity 等CI平台的环境中,分析速度提升效果最明显,尤其在代码量百万行以上的大型系统中表现稳定。

4. 使用预分析缓存提升复用率

Coverity支持结果缓存机制,在源文件未改动时跳过重新分析:

cov-analyze 会判断上次分析时该文件的哈希值;

若文件无变更,则直接复用先前的分析结果;

结合并行分析,可实现增量分析与并发执行的双重加速。

该策略尤其适合快速反馈周期要求高的敏捷开发团队。

二、Coverity并行分析如何提高效率

并行分析对分析效率的提升效果取决于项目规模、代码复杂度、分析粒度与计算资源的匹配度。以下几个方面具体体现了其提升性能的优势:

1. 减少整体分析时长

以一个典型的百万行C/C++项目为例:

单线程分析耗时可能在 2~3小时;

启用8线程并行后,分析时间缩短至 20~30分钟;

若使用4台服务器并发分析各模块,总时长甚至可控制在 15分钟内。

这种线性近似的加速效果,大大减轻了CI系统的资源压力。

2. 降低CI/CD阻塞时间

在DevOps流程中,代码提交后的自动分析越快越好。并行分析可有效降低:

代码提交→反馈之间的等待时间;

主干分支合并前的代码审查周期;

新版本交付前的QA瓶颈分析过程。

这意味着开发人员可以更快获取缺陷信息、尽早修复问题,整体开发迭代效率显著提升。

3. 提升资源利用率

并行分析可以充分利用多核服务器或云主机资源:

单核CPU在执行分析时往往存在等待I/O的瓶颈;

并发运行分析子进程可以让多核处理器持续处于高负载状态,提升硬件性价比;

分布式部署更可实现负载均衡、容错分析与分析集群的高可用性配置。

对于已具备高性能服务器的企业来说,并行分析是最具ROI的性能提升手段之一。

4. 优化大型代码库的可维护性

大型项目通常由多个团队并行开发多个模块,Coverity并行分析可配合模块级权限管理和结果隔离:

不同模块可独立分析、独立报告、独立修复;

有利于责任划分、降低协作冲突、提高修复追踪效率;

管理者可快速定位最易出错的组件,优先修复高危漏洞。

这对分布式开发、异地协作和供应链安全管控有极高实用价值。

三、Coverity并行分析的最佳实践与部署建议

尽管Coverity并行分析从技术层面大幅提升了分析速度与反馈效率,但要真正发挥其效能,还需要结合项目实际环境进行合理部署与调优。以下是一些在企业级实践中被验证有效的部署建议:

1. 根据代码结构设计模块化分析策略

建议将代码按功能组件或业务模块拆分,确保每个模块可以独立编译和分析。这样不仅支持并行分析,还便于模块级漏洞定位和权限隔离。

2. 在CI/CD中预留并行资源窗口

企业在使用Jenkins、GitLab CI等工具时,应设置并行 Job 参数,预分配分析任务所需CPU核数与内存资源,避免与构建、测试任务抢占资源。

3. 利用分析结果缓存构建增量分析机制

通过缓存历史分析数据,实现仅分析变更模块的“差量分析”,在并行的基础上进一步提升效率,同时也避免重复处理未修改代码。

4. 借助容器与云平台弹性扩展分析能力

结合Docker/K8s部署Coverity分析服务,可在高峰期自动横向扩展节点数量,适配大型代码合并或版本上线前的集中分析任务。

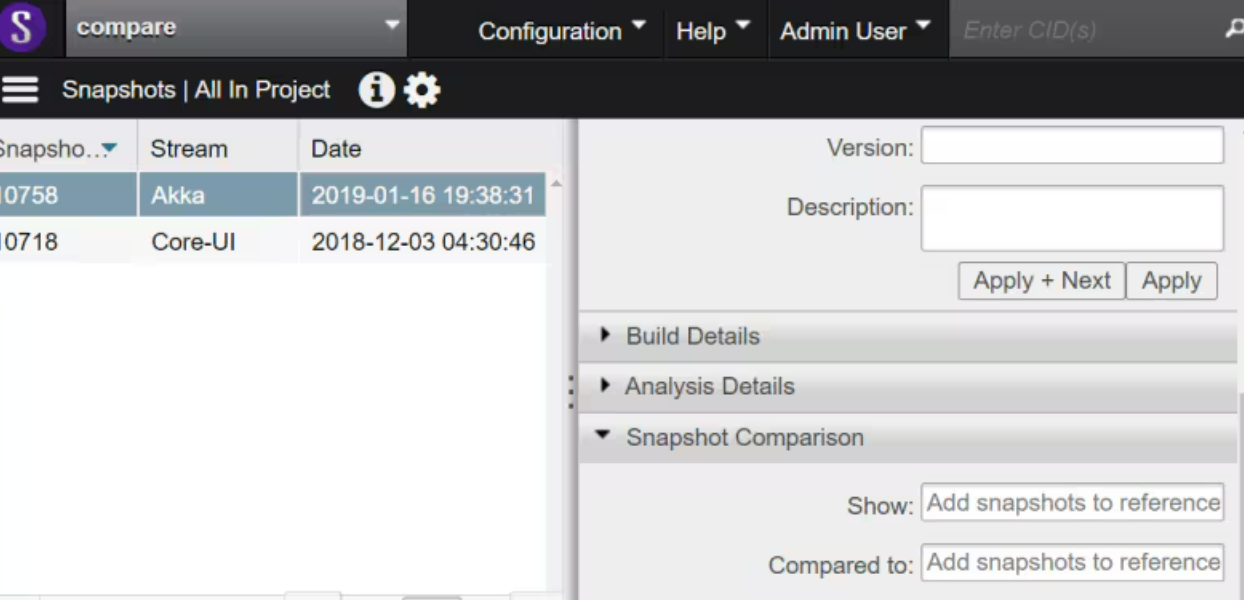

5. 管理平台统一调度与可视化追踪

推荐使用Coverity Connect等管理平台统一调度所有分析任务,同时将分析时间、任务进度、缺陷分布等可视化,有助于整体分析流程的透明化与协作优化。

通过这些策略,企业不仅能够在技术上充分释放Coverity并行分析的能力,还能在流程和组织层面构建起高效、稳定、可复制的代码质量保障体系。

总结

Coverity如何实现并行分析?它通过多线程执行、模块级拆分、分布式分析服务和分析缓存等机制,在架构层面打破了传统单核串行分析的瓶颈,为开发者提供了灵活高效的性能保障方案。而Coverity并行分析如何提高效率?则体现在整体分析时间缩短、CI流程加速、计算资源充分利用以及大型项目协作效率提升等多个方面。

在当前“快速迭代 + 安全优先”的开发环境中,高效的静态分析流程已不再只是一个“可选项”,而是衡量开发体系成熟度的重要标志。Coverity并行分析机制,正是在保障分析精度的前提下,为企业构建“快而准”的质量保障护城河,提供坚实的技术基座。